MakeGirlsMoeは

驚異的な生成画像の質で、お盆休み中の世間を驚かせた。

このMakeGirlsMoeの

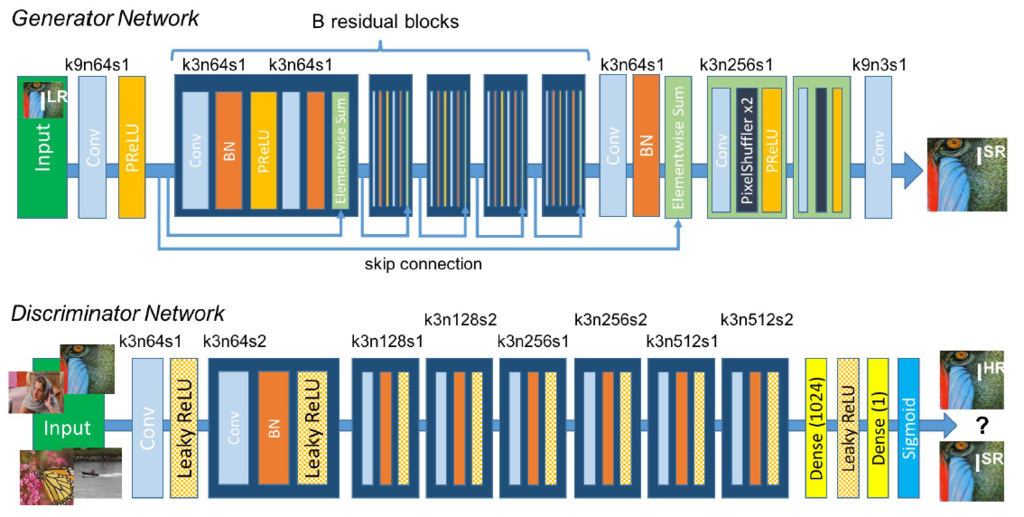

- ネットワーク構造(SRResNet)

- 目的関数(DRAGAN)

を使っていらすとや画像を生成してみる。

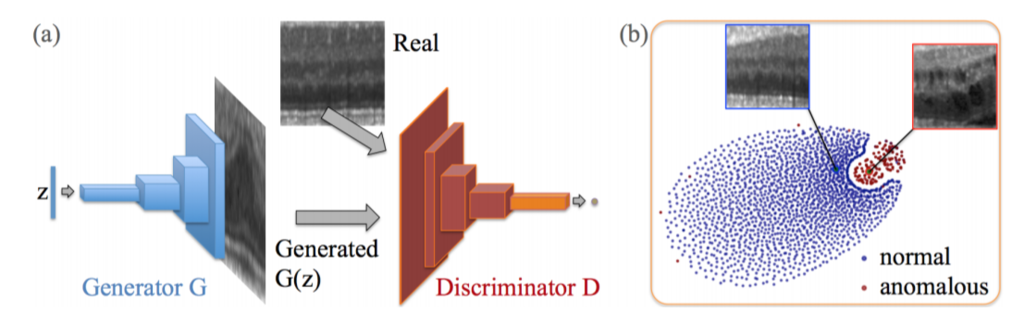

DRAGANについては、以前に記事を書いている。 当時あまり注目されていないながらも、私の手元のデータセットに関してはCramerGANやWGAN-gpよりも当時性能が出ていてビックリした。

SRResNetに関しては、https://arxiv.org/abs/1609.04802のネットワークをそのまま利用した。

通常のGANだと、アップサンプリングはdeconvolutionで行うが、SRResNetではPixelCNNを使う。

ResNetが深いので、メモリが4~8GしかないGPUだとあまりバッチサイズを大きく出来ず学習は厳しかった。

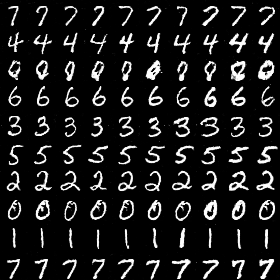

画像生成:ブロンド外国人による支配

これまでにない、とても鮮明な画像を生成できている。

しかしながら、生成画像に多様性はない。

何度か試したものの、いずれも

途中でブロンド外国人にmode collapseしてしまった。

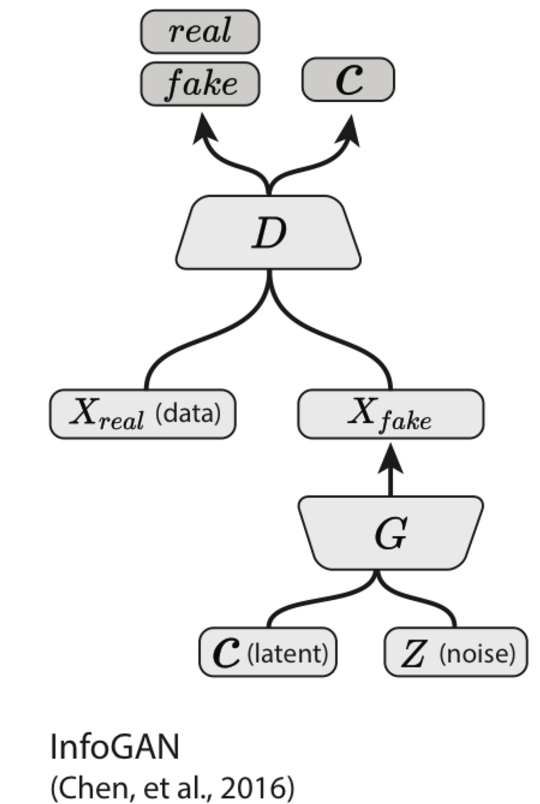

conditional GANにしないとそもそも多様性は保てない?のかもしれない。 cGANにすればコントロールは少なくともできるかも。 論文ではAC-GANを使っていたので次はそちらを試す予定。

パターン1

完全にブロンド少年しか生成しなくなった。

(↓に行くほど学習が進んだ時の生成画像)

パターン2

パラメータを少し変えた別の学習では、女性率高めになった

パターン3

目がチカチカする。