- Coarse-to-Fine Volumetric Prediction for Single-Image 3D Human Pose

- https://arxiv.org/abs/1611.07828

3次元関節推定問題に対して、

- volumetric heatmapを回帰させる

- 反復的なネットワークで段階的に精度を上げる

関連研究

- CNNによる三次元姿勢推定でよく行われるアプローチは、

三次元関節座標(x,y,z)を直接回帰問題として解くこと(Li et al.とTekin et al.)- 難しい問題となる

- Tompson et al.の論文やPfisterの論文にこのアプローチの欠点が記述されているようなので読みたい

- 伝統的な2段階で三次元姿勢推定する手法にも劣る

- こちらの手法ではCNNは2次元関節位置推定にのみ使われ、3次元姿勢は事後処理で別途推定される。

手法

Volumetric representation

volumetric representationを使う。

三次元空間をのvoxelに分割し、

関節が各voxelに存在する確率を推定させる。

教師データは三次元正規分布で作り、教師データとのL2距離を誤差関数とする。

volumetric representationの利点は、各関節の座標を直接回帰させる問題を、voxel ごと関節が存在する信頼度の推定問題とできること。 こちらの方がネットワークとしては勾配情報を伝搬しやすく学習しやすい。 二次元姿勢推定でも全く同じ話があった。

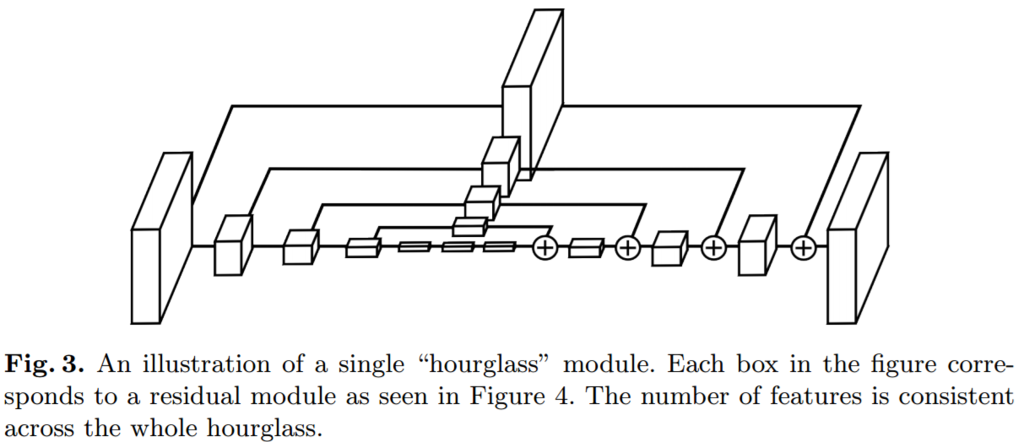

ネットワークの構造としては、hourglass型を使う。

Coarse-to-fine prediction

多段のstageを利用して反復的に精度を上げていく。

二次元姿勢推定で有効性が確認されている手法だが、

三次元の場合、例えばのvoxelを16個の関節分推定する必要があるとすると、400万voxel分推定することになる。

次元の呪いを避けるため、coarse-to-fine predictionの枠組みを使う。

最初の方のstageではvoxelのz次元(距離方向)に対する解像度を低くし、

後ろの方のstageでは解像度を徐々に上げていく。

評価

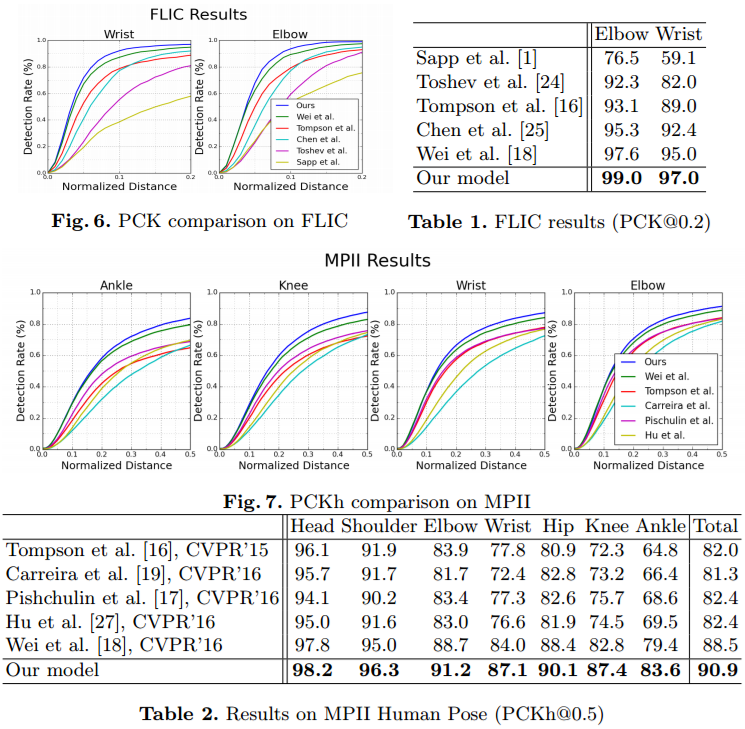

従来の座標を回帰させる方法(Coordinate Regression)と比べて、voxelの確率を回帰させる提案手法の有効性が明らかとなった。

他の代表的手法と比べてもSOTAであった。