広田研・廣瀬研にいたときに視触覚のクロスモダリティをテーマに研究をしていた。 GANの応用について調べていたら、同じクロスモダリティを扱った論文を見つけた。

Deep Cross-Modal Audio-Visual Generation https://arxiv.org/abs/1704.08292

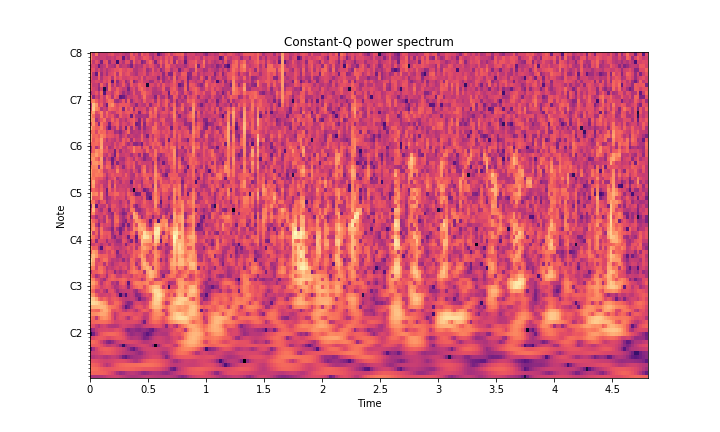

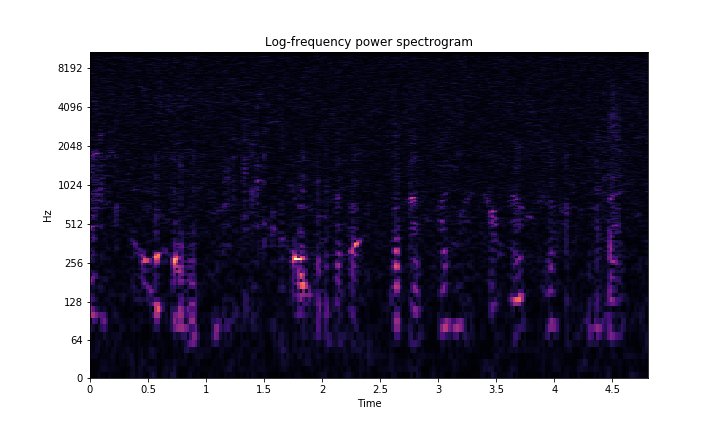

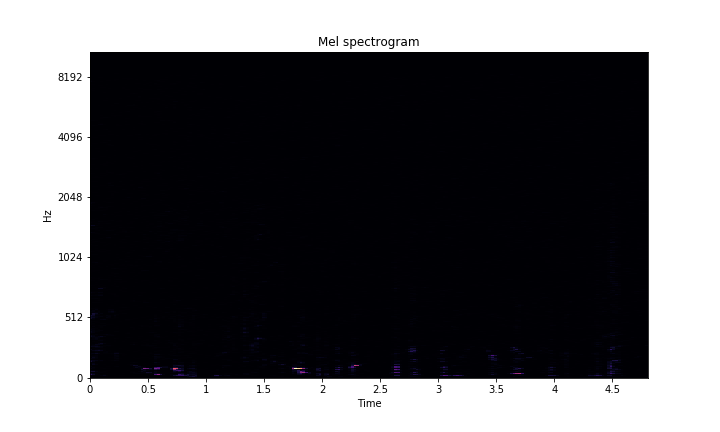

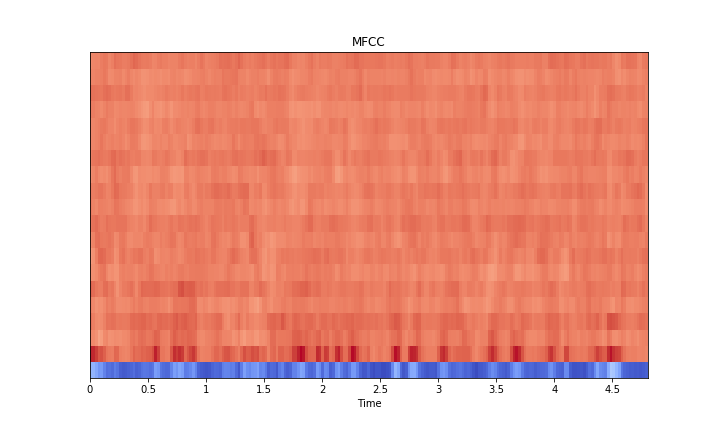

この中で音声信号を画像に変換する事前処理があるが、いくつかの種類が試されている。 それらを順にlibrosaを使って試してみた。

LMT Haptic Texture Databaseの音声信号(.wav)に対して適用してみる。 http://www.lmt.ei.tum.de/downloads/texture/

hamming windowを使い、サイズは50ms分となるように設定

STFT

log scaleで可視化

Mel-spectrum

MFCC

CQT