- Abnormal Event Detection in Videos using Generative Adversarial Nets

- https://arxiv.org/abs/1708.09644

- 異常検知の難しさ

- 既存の異常データセットのサンプルサイズが小さいこと

- 異常の定義がはっきりしていないこと

- これらの課題に対して、正常なパターンのみ学習させた生成モデルで対処

- 学習時には(集めやすい)正常データのみ用意

- 正常データとの距離により異常を判定

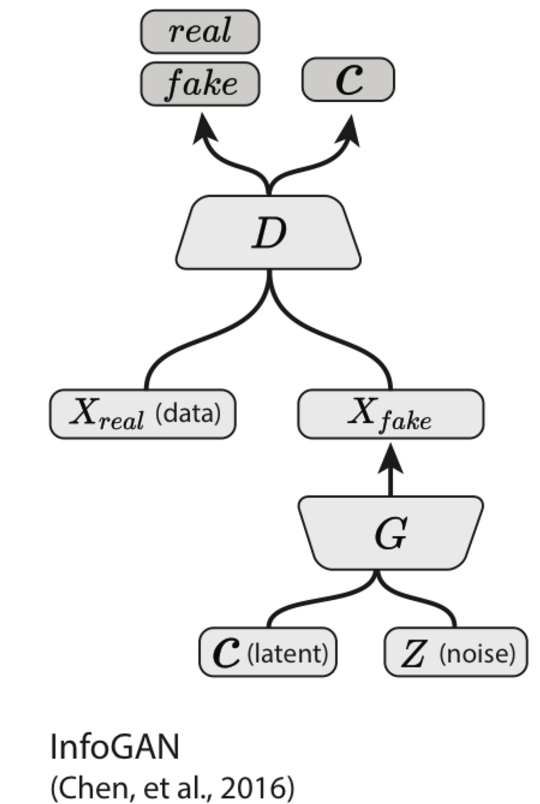

- 生成モデルとしてGANを利用

- GANを使った異常検知としては, https://arxiv.org/abs/1703.05921 もあったが,こちらとは異なる利用方法をしている

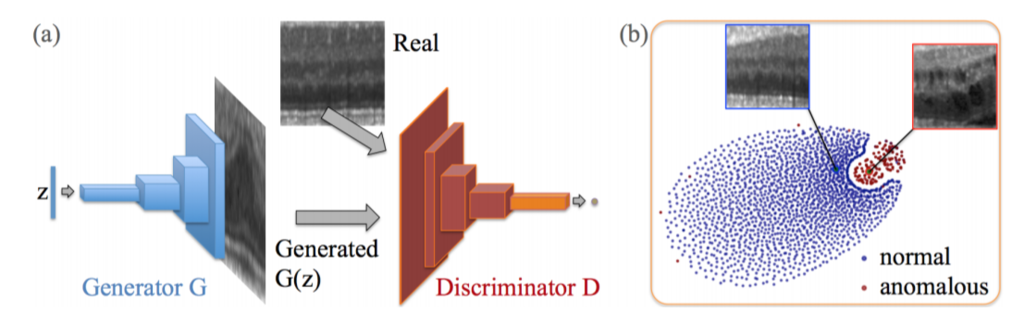

動画内の正常パターンを学習

時刻tにおけるフレームとそのときのオプティカルフロー

をデータとし,

pix2pixと同じ枠組みのネットワークを構築し正常パターンを学習させる.

2つのネットワークを組み,以下の変換をそれぞれ学習させる

(

)

(

)

正常の場合のみのデータで学習させておけば、

異常データとしてや

を入力したときには、変換が上手く行かないはず。

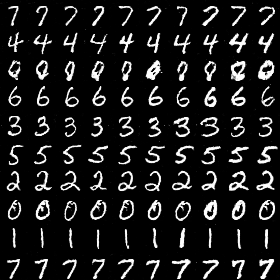

上の画像がその例になっている。

上部ではによって、車を含むフレーム

(異常パターン)からオプティカルフロー

を再構成しようとしているが、

車の部分のオプティカルフローがうまく再構成できていない。

下部ではによって、車を含むオプティカルフロー

からフレーム

を再構成しようとしているが,こちらも変な塊ができてしまっている。

テスト動画の判定はどのように行うかというと,テスト動画の各フレームからオプティカルフローを計算し,

フレームとオプティカルフローの組を作る.

そして,2つのネットワークでそれぞれ変換し,変換後のフレームとオプティカルフローと変換前の両者の差分から判定する.

具体的には,以下の2つを組み合わせて行う.