Tutorial on Variational Autoencoders(VAEs)を読み解いていこうと思う。

先人たちによる日本語の詳細な解説はネット上にゴロゴロあるので、

本記事は自分自身の理解のためのメモという位置づけ。

潜在変数

生成モデルは、高次元空間におけるデータ の分布

の分布 自体をモデル化するもののこと。

自体をモデル化するもののこと。

例えば、MNISTのような0〜9からなる手書き文字を生成する目的の生成モデルがある.

このとき、モデルの生成対象は0〜9の文字なので、

モデルはまずどの文字を生成するかを決めて、その決定のもとでデータを生成するものだ,と仮定してみる。

このときの予め決定しておくパラメータのことを潜在変数(latent variable)  と呼ぶ。

モデルが文字を描く前に、

と呼ぶ。

モデルが文字を描く前に、 を[0,…,9]からランダムにサンプリングするというイメージ.

なぜ「潜在」と呼んでいるかというと、どの潜在変数が文字を生成したかについては必ずしも知っておく必要がないため。

を[0,…,9]からランダムにサンプリングするというイメージ.

なぜ「潜在」と呼んでいるかというと、どの潜在変数が文字を生成したかについては必ずしも知っておく必要がないため。

潜在変数 を決める確率分布を

を決める確率分布を とする。

固定のパラメータ

とする。

固定のパラメータ のもとで、ランダムにサンプリングした

のもとで、ランダムにサンプリングした から、

から、 を生成する。

この

を生成する。

この が訓練データのものとよく一致すればよい生成モデルと言えそう.

が訓練データのものとよく一致すればよい生成モデルと言えそう.

数学的に記述すると、次のようになる。

$$

\begin{equation}

P(X) = \int P(X \, | \, z;\theta) P(z) dz \tag{1}

\end{equation}

$$

$$

\begin{equation}

P(X) = \int P(X \, | \, z;\theta) P(z) dz \tag{1}

\end{equation}

$$

訓練データ の周辺尤度を最大化することで,潜在変数

の周辺尤度を最大化することで,潜在変数 を推定する.

を推定する.

VAEでは、 はガウス分布をよく使う。

はガウス分布をよく使う。

この場合のガウス分布は

となる。

となる。

VAEs

VAEはいわゆるAutoencoderとはあまり関係がない。

ではなぜAutoencoderと呼ばれているかというと,最終的な目的関数を構成するのがencoderとdecoderからなるから.

上記の(1)を解くにあたって、VAEは以下の2つの問題を解決しなくてはならない。

- 潜在変数

をどう定義するか(どのような情報を表現するものと定義するか)

をどう定義するか(どのような情報を表現するものと定義するか)

- 潜在変数

の積分をどう扱うか。

の積分をどう扱うか。

1つめの問題は「文字の角度」「文字のストローク」「ストロークの太さ」「文字のスタイル」…など様々な性質が関わって複雑なため、できれば直接 の表す情報を決定するのは避けたい。

VAEではこの問題に対して、変わったアプローチをとっている。

それは、

の表す情報を決定するのは避けたい。

VAEではこの問題に対して、変わったアプローチをとっている。

それは、 を単純な分布、例えば正規分布

を単純な分布、例えば正規分布 からサンプリングするというもの。

本当にこのアプローチは正しいのだろうか。

からサンプリングするというもの。

本当にこのアプローチは正しいのだろうか。

実は 次元のどのような分布であっても、正規分布からサンプルされた

次元のどのような分布であっても、正規分布からサンプルされた 個の変数を複雑な関数でマッピングすれば表現可能なのである。

例として以下の図のようなリング状の二次元空間状の分布を得たい場合を考える。

正規分布からサンプルされた

個の変数を複雑な関数でマッピングすれば表現可能なのである。

例として以下の図のようなリング状の二次元空間状の分布を得たい場合を考える。

正規分布からサンプルされた を、

を、 で写像すると、うまいことリング状になる。

で写像すると、うまいことリング状になる。

(arxiv論文から引用)

(arxiv論文から引用)

したがって、表現力豊かな関数があるのであれば、normally-distributedな を用いて、目的の分布を得ることができ、訓練データ

を用いて、目的の分布を得ることができ、訓練データ を表現できる。

を表現できる。

を計算するためのコンセプトは明快。

を計算するためのコンセプトは明快。

をサンプリングする(

をサンプリングする( ![{\left[z_{1}, \cdots, z_{n} \right] }](http://chart.apis.google.com/chart?cht=tx&chl=%7B%5Cleft%5Bz_%7B1%7D%2C%20%5Ccdots%2C%20z_%7Bn%7D%20%5Cright%5D%20%7D) )

) を計算する

を計算する

ここでの問題は、

高次元空間の場合、正確に を推定するには、

を推定するには、 が非常に大きくなってしまうということ。

が非常に大きくなってしまうということ。

目的関数の設定

(1)式を簡単に計算する方法はなにかないだろうか?

よく考えると、大抵の に対して、

に対して、 はほぼ0となることに気づく。

大抵の

はほぼ0となることに気づく。

大抵の はなにも寄与しない。

はなにも寄与しない。

VAEはこの考え方を利用していて、 を生成するような

を生成するような のみをサンプリングしようとする。

のみをサンプリングしようとする。

そこで という新たな関数を考える。

この関数は、

という新たな関数を考える。

この関数は、 のもとで、

のもとで、 の分布を与えるもので、逆から考えるとその

の分布を与えるもので、逆から考えるとその は結局

は結局 を生成するようなものである。

このような

を生成するようなものである。

このような の空間は事前確率

の空間は事前確率 において極めて小さい。

これにより、例えば

において極めて小さい。

これにより、例えば の計算が簡単になる。

の計算が簡単になる。

一方、 の計算は簡単になるだろうか。

とりあえず最初にしてみるのは

の計算は簡単になるだろうか。

とりあえず最初にしてみるのは と

と の関係付けである。

の関係付けである。

と

と の関係は、変分ベイズで片付けられる。

まず

の関係は、変分ベイズで片付けられる。

まず と

と 間のKL divergenceを任意の

間のKL divergenceを任意の に対して定義する。

に対して定義する。

$$

D \left[ Q(z) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log Q(z) - log P(z \mid X) \right]

$$

$$

D \left[ Q(z) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log Q(z) - log P(z \mid X) \right]

$$

この式に対して、ベイズの定理を適用して変換して、さらに に無関係な項を期待値からはずす操作を施す。

に無関係な項を期待値からはずす操作を施す。

$$

D \left[ Q(z) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(X \mid z) - \log P(z) \right] + \log P(X)

$$

$$

D \left[ Q(z) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(X \mid z) - \log P(z) \right] + \log P(X)

$$

両辺にマイナスをかけて、期待値の項の中身の一部をKL divergenceに書き換える。

$$

\log P(X) - D \left[ Q(z) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z) \mid\mid P(z) \right]

$$

$$

\log P(X) - D \left[ Q(z) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z) \mid\mid P(z) \right]

$$

は固定値であり、

は固定値であり、 はあらゆる分布がありうることに注意しておく。

はあらゆる分布がありうることに注意しておく。

を推論することに興味があるため、

を推論することに興味があるため、 に依存するような

に依存するような を構築したい。

それはつまり

を構築したい。

それはつまり![{D \left[ Q(z) \mid\mid P(z \mid X) \right]}](http://chart.apis.google.com/chart?cht=tx&chl=%7BD%20%5Cleft%5B%20Q%28z%29%20%5Cmid%5Cmid%20P%28z%20%5Cmid%20X%29%20%5Cright%5D%7D) が小さくなるような場合。

が小さくなるような場合。

$$

\begin{equation}

\log P(X) - D \left[ Q(z \mid X) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z \mid X) \mid\mid P(z) \right] \tag{2}

\end{equation}

$$

$$

\begin{equation}

\log P(X) - D \left[ Q(z \mid X) \mid\mid P(z \mid X) \right] = \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z \mid X) \mid\mid P(z) \right] \tag{2}

\end{equation}

$$

この式はVAEのコアになる部分なので詳しくみていく。

- 左辺の

は最大化したい。

(一方で、左辺の

は最大化したい。

(一方で、左辺の![{D \left[ Q(z \mid X) \mid\mid P(z \mid X) \right]}](http://chart.apis.google.com/chart?cht=tx&chl=%7BD%20%5Cleft%5B%20Q%28z%20%5Cmid%20X%29%20%5Cmid%5Cmid%20P%28z%20%5Cmid%20X%29%20%5Cright%5D%7D) を最小化しつつ)

を最小化しつつ)

- 右辺は、勾配降下法でうまく

を選んでいけば最適化できる。

この右辺の項はAutoencoderとみなせる。

を選んでいけば最適化できる。

この右辺の項はAutoencoderとみなせる。

が

が を

を にencodeし、一方

にencodeし、一方 が

が から

から を復元しようとしている。

を復元しようとしている。

左辺では![{ D \left[ Q(z \mid X) \mid\mid P(z \mid X) \right]}](http://chart.apis.google.com/chart?cht=tx&chl=%7B%20D%20%5Cleft%5B%20Q%28z%20%5Cmid%20X%29%20%5Cmid%5Cmid%20P%28z%20%5Cmid%20X%29%20%5Cright%5D%7D) を最小化しつつ、

を最小化しつつ、 を最大化する。

を最大化する。

は解析的に計算できない。

しかし、左辺の二項目の

は解析的に計算できない。

しかし、左辺の二項目の は

は に近づいていくことを考えてみる。

もし、

に近づいていくことを考えてみる。

もし、 の表現力が高く、

の表現力が高く、 と近い場合には、これらの間のKL divergenceは0になる。

この仮定のもとでは

と近い場合には、これらの間のKL divergenceは0になる。

この仮定のもとでは  のみを最適化すればよい。

のみを最適化すればよい。

目的関数を最適化する

(2)の右辺をどのように最適化すればよいだろうか?

をどうするかという問いになるが、

普通は

をどうするかという問いになるが、

普通は  とする。

ここで

とする。

ここで と

と はパラメータ

はパラメータ を持つ任意の関数でデータから学習する。

実際、

を持つ任意の関数でデータから学習する。

実際、 と

と はニューラルネットワークで決める。

この手法は計算量は小さいのが利点。

はニューラルネットワークで決める。

この手法は計算量は小さいのが利点。

もうひとつの項は、![{D \left[ Q(z|X || P(z) \right]}](http://chart.apis.google.com/chart?cht=tx&chl=%7BD%20%5Cleft%5B%20Q%28z%7CX%20%7C%7C%20P%28z%29%20%5Cright%5D%7D) はKL divergenceである。

多変量ガウス分布のKL divergenceは、次のようなclosed formで書ける。

はKL divergenceである。

多変量ガウス分布のKL divergenceは、次のようなclosed formで書ける。

$$

D [ \mathcal{N}(\mu_{0}, Σ_{0}) || \mathcal{N}(\mu_{1}, Σ_{1}) ] = \frac{1}{2} \bigl( tr(Σ_{1}^{-1} Σ_{0}) + (\mu_{1} - \mu_{0})^{T} Σ_{1}^{-1} (\mu_{1} - \mu_{0}) -k + \log(\frac{det Σ_{1}}{det Σ_{0}}) \bigr)

$$

今回に適用するとシンプルになる。

$$

D [ \mathcal{N}(\mu_{0}, Σ_{0}) || \mathcal{N}(\mu_{1}, Σ_{1}) ] = \frac{1}{2} \bigl( tr(Σ_{1}^{-1} Σ_{0}) + (\mu_{1} - \mu_{0})^{T} Σ_{1}^{-1} (\mu_{1} - \mu_{0}) -k + \log(\frac{det Σ_{1}}{det Σ_{0}}) \bigr)

$$

今回に適用するとシンプルになる。

$$

D [ \mathcal{N}(\mu(X), Σ(X)) || \mathcal{N}(0,I) ] = \frac{1}{2} \bigl( tr(Σ(X)) + (\mu(X))^{T} (\mu(X) -k - \log det (Σ(X)) \bigr)

$$

$$

D [ \mathcal{N}(\mu(X), Σ(X)) || \mathcal{N}(0,I) ] = \frac{1}{2} \bigl( tr(Σ(X)) + (\mu(X))^{T} (\mu(X) -k - \log det (Σ(X)) \bigr)

$$

さて、(2)の式に戻る。

(2)の右辺第一項に対する対応は、 を1つサンプルして、それに基づく

を1つサンプルして、それに基づく を

を とみなすこととする。

とみなすこととする。

最後に、データセット全体からサンプル をとって期待値を計算すると、

最適化したい式は次のようになる。

をとって期待値を計算すると、

最適化したい式は次のようになる。

$$

\begin{equation}

E_{X \sim D} [ log P(X) - D[Q(z|X) || P(z|X)] ] = E_{X \sim D} [ E_{z \sim Q} [ log P(X | z)] - D[Q(z|X) || P(z) ]] \tag{3}

\end{equation}

$$

この式に基づいて勾配計算をするときには、期待値の中身を計算すればよい。

$$

\begin{equation}

E_{X \sim D} [ log P(X) - D[Q(z|X) || P(z|X)] ] = E_{X \sim D} [ E_{z \sim Q} [ log P(X | z)] - D[Q(z|X) || P(z) ]] \tag{3}

\end{equation}

$$

この式に基づいて勾配計算をするときには、期待値の中身を計算すればよい。

つまり と

と をサンプルして、以下の勾配を計算する。

をサンプルして、以下の勾配を計算する。

$$

log P(X|z) - D[ Q(z|X) || P(z) ]

$$

$$

log P(X|z) - D[ Q(z|X) || P(z) ]

$$

ところが実は![{\mathbb{E}_{z \sim Q}\left[log P(X \mid z)\right]}](http://chart.apis.google.com/chart?cht=tx&chl=%7B%5Cmathbb%7BE%7D_%7Bz%20%5Csim%20Q%7D%5Cleft%5Blog%20P%28X%20%5Cmid%20z%29%5Cright%5D%7D) の計算に際して 深刻な問題 がある。

の計算に際して 深刻な問題 がある。

は

は だけでなく

だけでなく にも依存している。

しかし、(3)ではこの依存が消滅してしまっている。

VAEを上手く機能させるためには、

にも依存している。

しかし、(3)ではこの依存が消滅してしまっている。

VAEを上手く機能させるためには、 を経た上で、

を経た上で、 が

が を復元させるようにする必要がある。

を復元させるようにする必要がある。

下図の(左)が問題を示している。

(arxiv論文から引用)

(arxiv論文から引用)

forward passは問題ない。

しかしbackpropagate時に、計算グラフが途切れているため、誤差を から

から へ伝播することができない。

へ伝播することができない。

ここで reparameterization trick を使う。

この手法ではサンプリング操作の代わりに を

を の出力結果を元に関数で生成する。

具体的には、

の出力結果を元に関数で生成する。

具体的には、 と

と のもとで、

のもとで、 として

として を計算する。(ここで

を計算する。(ここで は最適化とは無関係のハイパーパラメータ)

よって実際に勾配を取る式は次のようになる。

は最適化とは無関係のハイパーパラメータ)

よって実際に勾配を取る式は次のようになる。

$$

E_{X \sim D} \left[ E_{\epsilon \sim N(0, I)}[log P(X|z = \mu(X) + Σ^{½} \odot \epsilon)] - D[Q(z|X) || P(z) ] \right]

$$

$$

E_{X \sim D} \left[ E_{\epsilon \sim N(0, I)}[log P(X|z = \mu(X) + Σ^{½} \odot \epsilon)] - D[Q(z|X) || P(z) ] \right]

$$

学習済みモデルを試すためには

新しいデータを生成したい時には、decoderに を投入する。

単純にVAEからencoderを取り除く操作となる。

を投入する。

単純にVAEからencoderを取り除く操作となる。

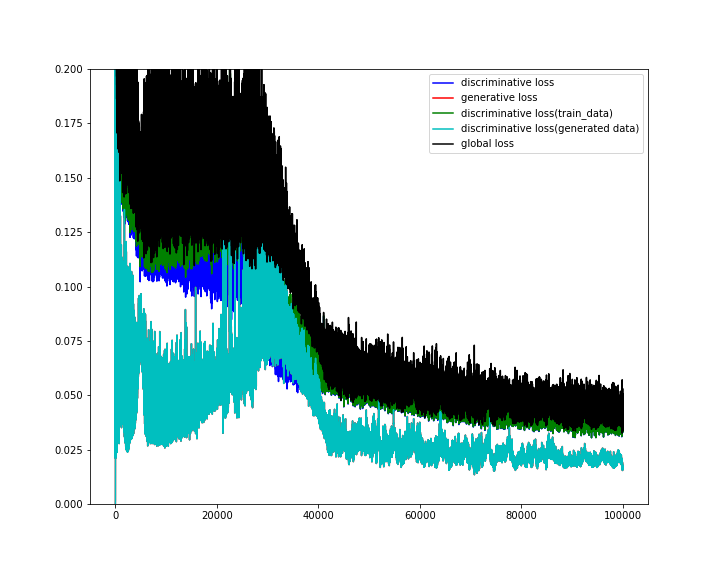

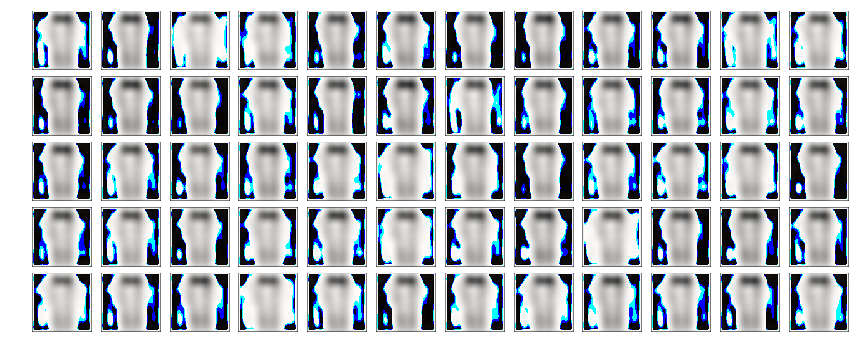

いらすとや画像を生成してみる

VAEをtensorflowで実装し,

いらすとや画像を生成してみた.

実装に誤りがあるのか,

現状うまく生成できなかった..

mode collapseが起きている。

(追記)

上の記述だと,

式変形を追いにくいので,全体の変形をまとめて書いてみる.

上よりも式変形を補った.

$$

\begin{align}

D \left[ Q(z) \mid\mid P(z \mid X) \right] &= \int Q(z) [\log Q(z) - \log P(z \mid X)] dz \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(z \mid X) \right] \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(X \mid z) - \log P(z) + \log P(X) \right] \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(X \mid z) - \log P(z) \right] + \log P(X) \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(z)\right] - \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] + \log P(X) \\

&= D \left[ Q(z) \mid\mid P(z) \right] - \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] + \log P(X)

\end{align}

$$

左辺と右辺を入れ替えて,

$$

\begin{align}

D \left[ Q(z) \mid\mid P(z \mid X) \right] &= \int Q(z) [\log Q(z) - \log P(z \mid X)] dz \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(z \mid X) \right] \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(X \mid z) - \log P(z) + \log P(X) \right] \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(X \mid z) - \log P(z) \right] + \log P(X) \\

&= \mathbb{E}_{z \sim Q} \left[ \log Q(z) - \log P(z)\right] - \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] + \log P(X) \\

&= D \left[ Q(z) \mid\mid P(z) \right] - \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] + \log P(X)

\end{align}

$$

左辺と右辺を入れ替えて,

$$

\begin{align}

\log P(X) - D \left[ Q(z \mid X) \mid\mid P(z \mid X) \right] &= \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z \mid X) \mid\mid P(z) \right] \\

\log P(X) & \geq \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z \mid X) \mid\mid P(z) \right] = L(\theta, \phi; x)

\end{align}

$$

左辺を最大化する代わりに右辺を最大化する.

$$

\begin{align}

\log P(X) - D \left[ Q(z \mid X) \mid\mid P(z \mid X) \right] &= \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z \mid X) \mid\mid P(z) \right] \\

\log P(X) & \geq \mathbb{E}_{z \sim Q} \left[ \log P(X \mid z) \right] - D \left[ Q(z \mid X) \mid\mid P(z) \right] = L(\theta, \phi; x)

\end{align}

$$

左辺を最大化する代わりに右辺を最大化する.

から1つのアクション

を選択する。

その後に、コスト関数

が提示され、その回のコスト

が決まる。

この操作を何回も繰り返していく。

回目のアクションを

、コスト関数を

とする。

コスト関数

は毎回全く違っていても、同じでも構わない。

を最小化できるか。

そもそもコスト関数

がわからない場合でも、合計コストを最小化できるような戦略をとることができるのか。

とする。

このとき、ある戦略

のリグレットは次のように定義される。

による合計コストとの差を戦略

のリグレット

という。

$$

Regret_{T}(A) = \sum_{i} f^{(t)}(\theta^{(t)}) - \sum_{i}f^{(t)}(\theta^{\ast})

$$

最適な固定戦略をとっている場合と比べて、現在の戦略がどれだけ悪いのかを測り、「あの固定戦略をとっていれば」と考えるのでリグレットと呼ばれる。

回目のアクション

を次のように決定する。

$$

\theta^{(t)} = \arg \min \sum_{i=1} f^{(t)}(\theta)

$$

この戦略はFollow The Leader(FTL)と呼ばれる。

一見うまくいくように見えるが、評価するコスト関数

はこれまでのコスト関数とは関係ないかもしれない場合には対応できない。

回目のアクション

を次のように決めることを考えてみる。

$$

\theta^{(t)} = \arg \min \sum_{i=1} f^{(t)}(\theta) + R(\theta)

$$

ただし、

は凸関数であり、

はどの程度正則化を考慮するかのパラメータ。

この戦略をRegularized Follow The Leader(RFTL)と呼ぶ。

を、

$$

\lambda = \max \, f^{(t)T} (\nabla^{2}R(\theta))^{-1} f^{(t)}

$$

とし、

を、

$$

D = \max R(\theta)-R(\theta^{(1)})

$$

とすると、

$$

Regret_{T}(A) = \sum_{i} f^{(t) T}(\theta^{(t)} - u) \leq 2 \sqrt{2 \lambda D T}

$$

と

が含まれている。

この2つの値はトレードオフの関係にある。

もし

を小さくしたいのであれば、(

なので)、

と

が小さくなるような

を使いたくなる。

しかしその場合、

の各要素は小さく、その逆行列は大きくなるため、

は大きくなる。

問題の特徴を活かして、

と

の両方が小さくなるような正則化関数、コスト関数を設計する必要がある。